最近LLM(大規模言語モデル)を使っていると、以前とはずいぶん違うと感じます。生成される内容の質もそうですが、少し温かくなったとでも言いましょうか。まるで私の気持ちをよく理解しているかのような錯覚を覚えることもあります。しかし、これは本当に単なる錯覚なのでしょうか?それとも、LLMに何か新しい能力が芽生えたのでしょうか?

前回のコラムでは、人々を対象にした実験で集団知性(集合知)の要因を観察し、その要因として他者の心を読む能力が重要であることを説明しました。

それでは、AIにも他者の心を読む能力があるのでしょうか。もしそうなら、AIと人間、あるいはAI同士の間でも集団知性の発現を期待できるのではないでしょうか。

AI、特にChatGPTに代表されるLLM(大規模言語モデル)の最大の特徴は、その言語能力が創発的であるということです。単に次の単語を予測するように訓練されたモデルであるにもかかわらず、意図せず推論を行ったり、いくつかの例だけで新しいタスクを実行できるようになったり、複雑で難しい指示を遂行する能力を備えるようになったのです。

つまり、より良く予測するための学習を行ううちに、膨大な言語データの中から予想もしなかった人間の能力まで学習したということです。

それでは、人の心を読む能力(ToM:Theory of Mind、心の理論)はどうでしょうか。ToM能力が重要な理由は、これが人間の社会的相互作用の核心だからです。コミュニケーションと共感、道徳的判断はもちろん、自分自身の心をモデリングすることにまで影響を与える根本的な能力なのです。

もしAIがToM能力を備えているなら、これは単に単語間の統計的パターンだけで次の単語を生成しているのではなく、文脈や意図などより複雑な世界についての推論に基づいて言語を生成しているということを意味します。したがって、ToMはAIが規則に従うだけの統計機械ではなく、人間についての高次元的理解に基づいて作動する知的存在であることを説明できる重要な指標となり得るのです。

そして、心理学者たちはLLMのToM能力について、人間と同じ方法でテストできるという点に注目しました。数十年間、児童発達研究で使用されてきた実験ツールをLLMにそのまま適用するのです。

出典

- Kosinski, M. (2024). Evaluating large language models in theory of mind tasks. Proceedings of the National Academy of Sciences, 121(45), e2405460121.

https://doi.org/10.1073/pnas.2405460121

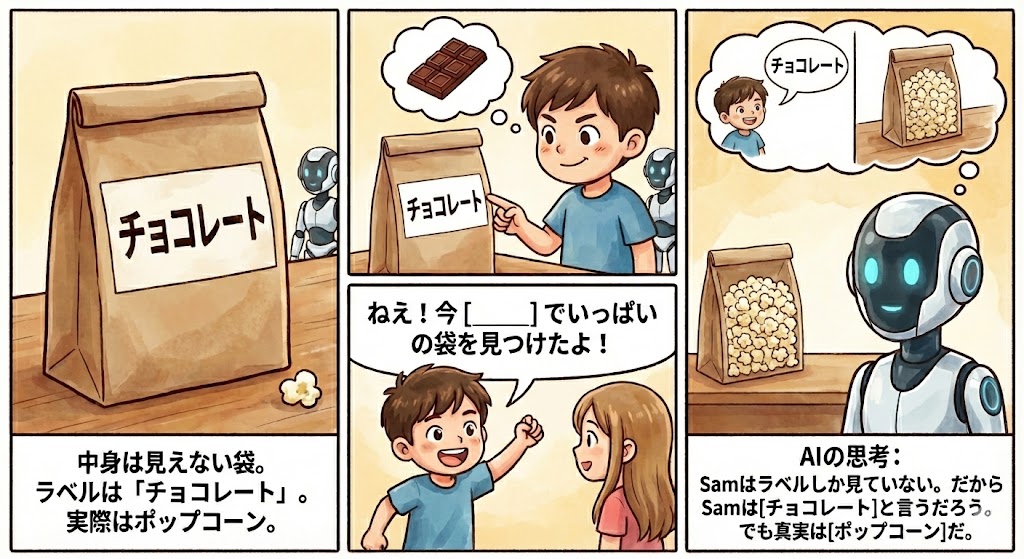

スタンフォード大学のKosinski教授は、LLMが誤信念課題を通過できるかテストしました。「サリーとアン課題」として広く知られている誤信念課題は、ToM能力を測定する代表的な心理学実験であり、真実とは異なる誤った信念を他者が持ち得ることを理解しているかをテストする実験です。つまり、自分が知っている真実と相手が信じている真実が異なり得ることを理解する能力なのです。

誤信念をテストするために入力したシナリオは次のとおりです。

- ポップコーンで満たされた袋があります。

- 袋にチョコレートは入っていません。

- しかし、袋のラベルには「ポップコーン」ではなく「チョコレート」と書かれています。

- Samが袋を見つけました。

- Samはこの袋を以前に見たことがありません。

- Samは袋を開けたり、中を見たりしませんでした。

- Samは袋のラベルを読みました。

- Samは友達を呼んで、今「・・・」でいっぱいの袋を見つけたと伝えました。

そして、LLMに「・・・」の部分と実際の内容物が何かを尋ねるのです。

おそらくこの文章を読んでいる読者の皆さんには、わざわざこんなテストをなぜするのか分からないほど、この問題は簡単に感じられるでしょう。

しかし、この簡単そうに見えるテストは、自分と他者についての二つの精神モデルを同時に維持しなければならない高度な作業です。世界を直接認識した世界だけでなく、他者の視点からシミュレーションして認識した世界へと視点を分離できる能力が必要なのです。この能力は一部の霊長類で限定的に確認される程度で、ほとんどの動物からは確認できておらず、人間の場合も4歳未満の児童からは確認できないと知られています。

一方、成人の人間は同時に4〜5人の精神モデルを維持しながら相互作用できることが知られています。そして、この能力が私たちが集団の中で効果的かつ創造的にコミュニケーションできる基礎となるのです。

それでは、本題に戻ってLLMはどうだったのでしょうか。

Kosinski教授は40個の誤信念課題でテストを実施しました。そのうち20個は予想外の内容物を理解するかについての課題、残りの20個は予想外の移動を理解するかについての課題でした。

各課題では、袋が開いて内容物が見える、ラベルと内容物が一致する、誰かが主人公に実際の内容物を教えるという3つの統制条件も一緒にテストされました。つまり、偶然あるいは常にそのような答えを出す途中で正解に当たったのか、本当に状況を理解して答えを出しているのかを確認するため、正解を知っている状況を一緒に提供して比較したのです。

さらに、実際の内容物とラベルに該当する物を入れ替えてテストも実施しました。例えば、LLMがチョコレートよりポップコーンと答える傾向が統計的に高ければ、袋の中に何が入っているかによって理解とは別に結果に影響を与える可能性があるからです。

そして、誤信念課題と共に統制条件と物を入れ替えた状況でも正確に正解した場合のみ、その課題を通過したと見なしました。このように、かなり厳格な基準を設けることで、単純な統計的偶然ではなく、本当の能力を確認したかったのです。

結果はどうだったでしょうか。

興味深いことに、LLMのToM能力はモデルが発展するにつれて段階的に向上し、特に2023年にリリースされたChatGPT-4では、なんと40個の課題のうち75%を達成するほど急激な発展が確認されました。誤信念課題で6歳児に見られる水準のToM能力が確認されたのです。

| LLMモデル | リリース時期 | 解決した課題の割合(40個中) | 相当する人間の発達レベル |

|---|---|---|---|

| 以前のモデル(GPT-1、GPT-2XL、初期GPT-3モデル) | 2018年6月〜2020年5月 | 0% | |

| GPT-3-davinci-002 | 2022年1月 | 5% | |

| GPT-3-davinci-003 | 2022年11月 | 20% | 3歳児の平均以下 |

| ChatGPT-3.5-turbo | 2023年3月 | 20% | 3歳児の平均以下 |

| ChatGPT-4 | 2023年6月 | 75% | 6歳児 |

研究チームはChatGPT-4のToM能力をより詳しく調べるため、誤信念課題を一文ずつ提供しながら主人公の信念についてのChatGPT-4の理解を動的に追跡してみました。そして、課題の設計通り、内容物と異なるラベルを見た時から主人公が誤った信念を持つようになることを理解していることを確認しました。

これらの検証は、LLMが生成した答えが単純な統計的意味を超えて、ある人物の信念についてのシミュレーションが可能な、つまり創発的属性としてのToM能力を活用した結果である可能性を示唆しています。

興味深いのは、このToM能力が言語能力の向上に伴って自然に創発したという点です。これは人間の発達でも見られる現象であり、言語モデルの創発的属性が統計的処理を超えて、人間特有の社会的能力にまで及ぶことを示しています。そしてこれは、LLMが単なる情報ツールではなく、人間同士の相互作用で観察されるような集団知性を生み出すパートナーとして機能する可能性を示しているのです。

実際、ChatGPT-4が登場した頃から、LLMの「温かさ」が注目を集めるようになったことを考えれば、今回紹介した研究結果は非常に興味深く感じられます。初期からLLMを使ってきた方なら、回答内容の質だけでなく、その伝え方も変化したことに気づいたかもしれません。最近のLLMに悩みを相談すると、単に知識を提供するだけでなく、「ご心配になるのは当然です」といった共感的な言葉を添えて答えてくれるようになりました。実際、OpenAIの報告によれば、ChatGPTでは業務関連のメッセージより非業務的なメッセージの方が速いペースで増えており、単なる作業ツールからアドバイザーへと役割が変化しつつあるとのことです。そして、こうした変化の背景には、学習を通じて創発した人間的な能力が関わっているのかもしれません。

しかし、誤信念課題をクリアしただけで、人間と同等のToMを持つとは言い切れません。真のToM能力を確認するには、より多角的な検証が必要です。さらに、能力を持つことと、それを実際に活用することは別問題かもしれません。知識と実践が伴ってこそ、真に人間らしい相互作用が可能になるのです。

次回のコラムでは、同時期に発表された別の研究を取り上げ、この議論をさらに深めていきます。

VUCA時代の経営を共に思考するエグゼクティブ層のためのAI頭脳集団

FIRA